ローカルLLMを使えば、自分のPCだけでAIが使えます。

ということで、色々やってみたので備忘録。簡単にですが、ローカルLLMのやり方も解説。ChatGPTのようなAIをオフラインで使いたい人は、ぜひやってみて下さい。

ローカルLLMのあれこれ

いきさつ

動画にコメントくださるaroooyさんが、Youtubeで「ローカルLLM用にグラボ買った話」をしていて、そこでふと私もやりたいなーと思って調べてみました。

ちなみに、aroooyさんのブログはこちら。

GoProなどめちゃくちゃ詳しいので、性能面などの深い考察を知りたい人はとても参考になりますよ。映像に関する知識量がかなりすごい。

ローカルLLMとは?

ローカルLLMとは、いわゆる自分のPCで構築するAI環境のこと。

ChatGPTみたいな大規模言語モデル(LLM)を 自分のPCやサーバーの中で動かす環境のことを指す。

おとこ

おとこそんなことができるの?難しくないの?

実は、簡単にできます。

ローカルLLMの良いところと悪いところ

ローカルLLMには、当然ながらメリットとデメリット両方ある。

| 良い点 | 悪い点 |

|---|---|

| プライバシーが強い オフラインでも使える 無料で | PCの要求スペックが高い パーツの消耗が激しい 最新AIと比べると性能が落ちる |

特に良い所は、自分のPC内ですべて完結できるところ。データが外部に漏れないので、機密性の高い作業をやる場合には最適。

仕事などで外部に漏らしたくない情報がある場合には、重宝するだろう。

オンラインにあるAIは、情報流出が怖いですよね。学習されないようにすることはできるんだけど、どこまで信用して良いのやらって感じで。そういう人はやってみる価値あり。

最大のデメリットは、PCの要求スペックが高いことで、少なくともパーツ(特にGPU)に数万の投資をしないとまともに動かせない。

下位モデルのAIなら、ミドルスペックでも十分動かせるとは思う。ただし、PCスペックがそのままAIの賢さに直結するので、馬鹿な回答なんかを連発されるともどかしいかもしれない。

とはいえ、試すことはできるので、興味のあるひとは以下をやってみて欲しい。

ということでやってみた

実際にやってみましたが、かなり簡単でした。

「LM Studio」というのを使えば、それだけで完結します。

ローカルLLMの構築の仕方

- LM Studioをインストール

- モデルを検索してダウンロード

- チャット開始

たったこれだけです。まさかLM Studioだけで完結するとは思いませんでしたね。これがあれば、ChatGPTのような感じで使えます。

「LM Studio」は、下記のリンクからDL出来ます。無料です。

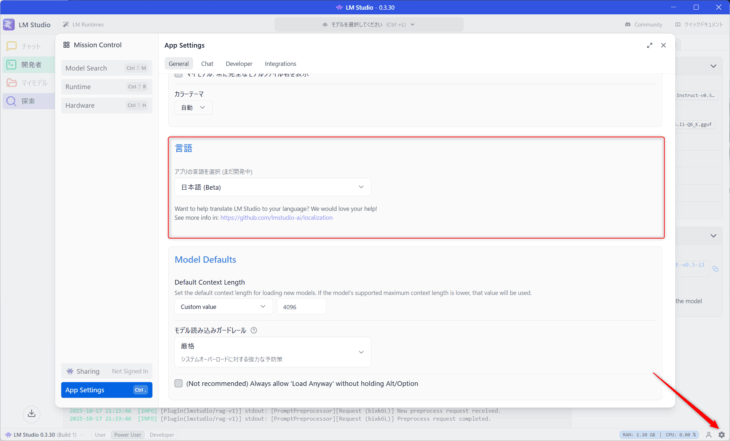

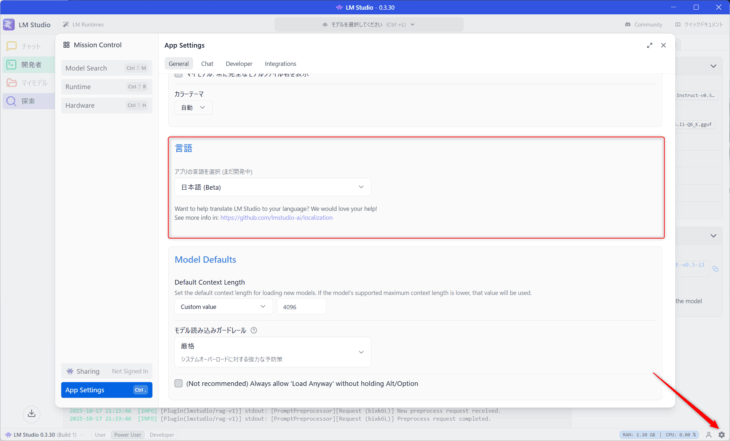

日本語化

ちなみに、日本語化できます。

右下のアイコンから日本語に変更しておこう。

問題はモデル選び

難しいのはモデル選び。

何が難しいの?

モデルの種類がたくさんあるからね。ぶっちゃけ調べながらやらないとわけがわからないよ。ここは、ChatGPTなどのオンラインのAIに頼ろう!

自分のPCのスペックをAIに言って、自分に合うレベルのモデルを入れる感じです。実際に動くかどうかは何度も確認する必要あり。

ちにみに、私のPCのスペックはこんな感じ。

| CPU | i9 14900K 3.2Ghz |

|---|---|

| メモリ | 64GB |

| グラフィックボード | RTX 4070 Ti Super 16GB |

| ストレージ | M2 SSD |

自作してます。

動画編集をやるので、かなり良いスペックにはしてあるんですが、LLMはこれでもちょっと厳しい感じです。「GPUもっと上のにしないと」って感じ。

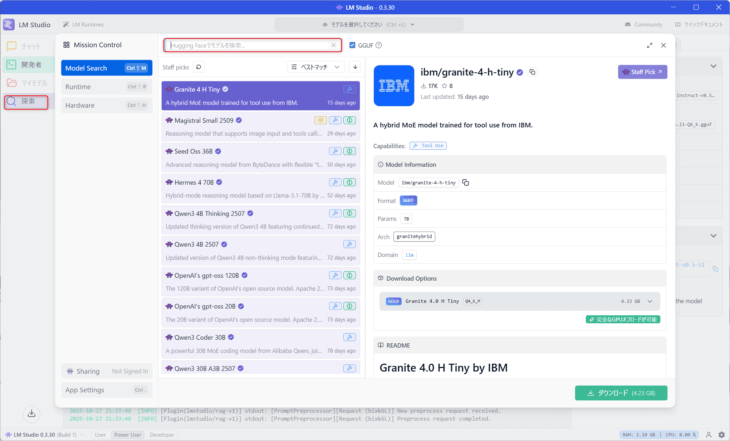

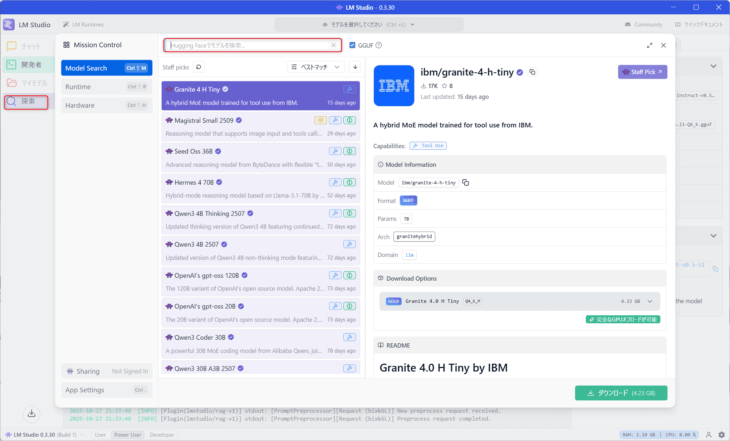

モデルは検索からDLできる

LM Studioの検索から、モデルを自由にDLできます。

何個も入れてみて、動作がスムーズな奴を選びましょう。容量が結構多いので注意。

選んだモデル

私のPC環境下で、スムーズに動いたのは以下のモデル。

llma-3.1-swallow-8b Q6

これならわりとスムーズにいきました。長文もぎりいけます。ちょっと遅いけど。

gemma-3-12bもかなりスムーズでした。27bだと遅いですね。70はさらに遅い。

【追記】結局、動作は遅めだけど20~30くらいのモデルを使ってます。おすすめのやつとかはあとでまとめるかも。

ぶっちゃけ使える?使えない?

これは用途によると思うけど、十分使えます。

試しに文章を校正させてみたところ、わりと望み通りになりますね。モデルによって得意不得意があるみたいですが、十分実用レベルかと。

現状、最高峰のモデルでも「ChatGPT4レベル」くらいらしいんですが、今のところローカルでも結構あたまいいなぁって印象ですね。

スペックさえ足りてればかなりロマンがあるとおもいます。もっと進化してくれたら最高だなぁ。

あなたも自分だけのAIを持ってみてはいかがでしょうか。